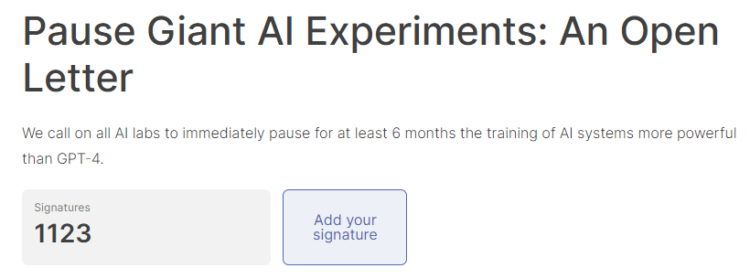

AIの安全性やリスクについて考え、人々に有益になるよう導くことを目的とした非営利団体であるFuture of Life Institute(FLI)は、2023年3月28日に、「GPT-4を上回るAIの研究を少なくとも6か月間、ただちに停止すること」を求める書簡を公開し、すでに1100人を超える署名が集まっています。

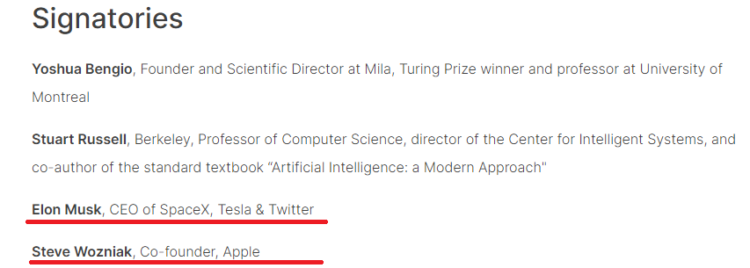

この署名には、イーロン・マスク氏や、スティーブ・ジョブズが崇拝した天才プログラマであるスティーブ・ウォズニアック氏らが署名しています。

本書簡で述べられている問題点

本署名の意図を簡単にまとめると、以下のようになります。

AIの開発が制御不能な競争になってしまっている

高度なAIは地球上の生命の歴史に大きな変化をもたらす可能性があり、相応の配慮とリソースをもって計画・管理されるべきものです。しかし、残念ながら、このような計画や管理は行われていません。(中略)

AI研究所は、その作成者でさえも理解できず、予測できず、確実に制御できない、より強力なデジタルマインドを開発・展開するための制御不能な競争に陥っているのです。

AI開発をするにあたって、じゅうぶんな計画や管理がされていない。作成者ですらAIの全容を把握しておらず、制御不能になっているといいます。

我々は非人間的なAIにコントロールされていいのか?(いや、よくない)

私たちは、機械が私たちの情報チャネルをプロパガンダや真実でないもので溢れさせるべきでしょうか?充実した仕事も含めて、すべての仕事を自動化すべきでしょうか?私たちは、文明のコントロールを失うリスクを冒すべきなのでしょうか?

我々人間にとってかわるかもしれないAIを野放しにしてていいのか?私たちがやりがいを感じている仕事まで奪っていいのか?という主張です。昨今話題の「AIに仕事を奪われる問題」「AIに支配される問題」が焦点となっています。

休止させて何するのか

明確なAI開発のルールを設立する

書簡には、「この休止期間を利用して、独立した外部の専門家によって厳格に監査・監督される、高度なAIの設計・開発に関する一連の共有安全プロトコルを共同で開発・実施すべき」と述べられています。

この「休止」は、AI開発の全てを休止させるものではなく、出現する能力を持つ予測不可能なブラックボックスモデルをますます大きくする危険な競争を鎮める意図だといいます。

AIガバナンスを確立させる

書簡には、「AI開発者は強固なAIガバナンスシステムの開発を行わなければならない。AIシステムの監視と追跡、本物と合成を区別しモデルの流出を追跡するための証明と透かしシステム、AIによる被害に対する責任、AIが引き起こす経済的・政治的混乱に対処するための十分にリソースを確保できる制度が必要」と述べられています。

なお、一時停止がすぐにできない場合には、政府が介入して猶予期間を設定する場合もあるということです。

この書簡が目指すところとは

本書簡では、AIシステムの開発は以下のようにするべきだと主張しています。

AIの研究開発は、今日の強力な最先端システムを、より正確で安全、解釈可能、透明、堅牢、連携、信頼、忠実なものにすることに再注目されるべきです。

「停止期間」のうちに、今あるAIの恩恵をしっかりと享受し、さらに強力なAIが開発されたときに制御不能な状態に陥らないようにしましょうとも記述されています。

強力なAIシステムの創造に成功した今、私たちは「AIの夏」を楽しむことができます。当団体は、社会に壊滅的な影響を与える可能性のある他の技術に対して一時停止の命令を行いました。 長いAIの夏を楽しみ、準備不足のまま秋に突入しないようにしましょう。

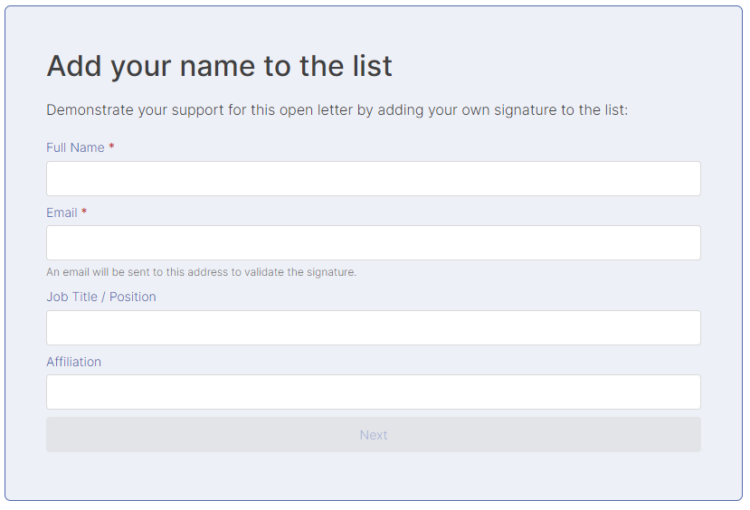

署名はまだ受付中

署名はまだ受付中であり、ホームページから誰でも名前を追加することができます。

まとめ

ChatGPTに対抗するサービスである「Bard」をGoogleがプレビュー版として一部ユーザーに公開するなど、AIの開発競争は激化しているなという実感はあります。ただ、人工知能をユーザーとして活用している身としては、このままどんどん性能が上がっていったら有難いなと思ってしまいます。

署名した著名人たちの手がけるサービスには、AIが搭載されるとより一層便利になりそうなものも多いきがしますが、なぜ署名したのか、その想いを聞いてみたいものです。

ソース:https://futureoflife.org/open-letter/pause-giant-ai-experiments/

コメント